Harnessing the Power of LLMs in Practice A Survey

1 INTRODUCTION

- If you want to use the LLM effectively and effciently,you have to

know the models’ capabilities and limitations. - After reading,you will know how to choose the most suitable LLM(

model sizes,computational requirements and the availability of

domain-specific pre-trained models.

Structure as follow:

- introduce LLM by discussing GPT BERT.

- delve into the critical factors that influence model from

different aspects. - dive deep into various concrete NLP tasks

2 PRACTICAL GUIDE FOR MODELS

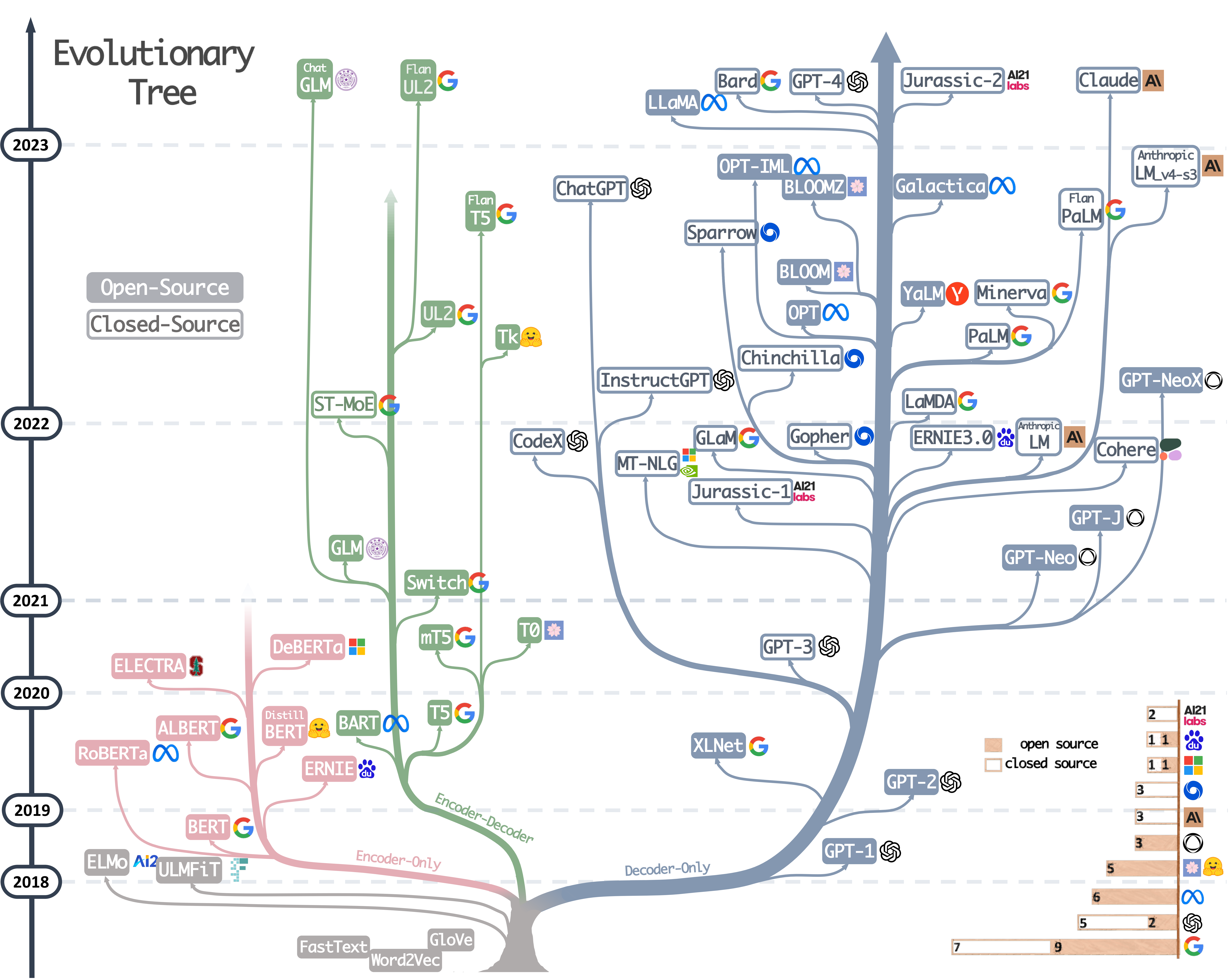

Three type:encoder-decoder or encoder-only language models

and decoder-only language models.

Different

| Characterustuc | LLMS | |

|---|---|---|

| Encoder-Decoder or Encoder-only | Training: Masked Language Models Model type: Discriminative Pretrain task: Predict masked words | BERT、RoBERTa、T5 |

| Decoder-only | Training: Autoregressive Language Models Model type: Generative Pretrain task: Predict next word | GPT-3,OPT,GLM |

2.1 BERT-style Language Models: Encoder-Decoder or Encoder-only

MLM,

2.2 GPT-style Language Models: Decoder-only

neeed fine-tuning on datasets of the specific downstream task.

via prompting and in-context learning Autoregressive Language Models

3 PRACTICAL GUIDE FOR DATA

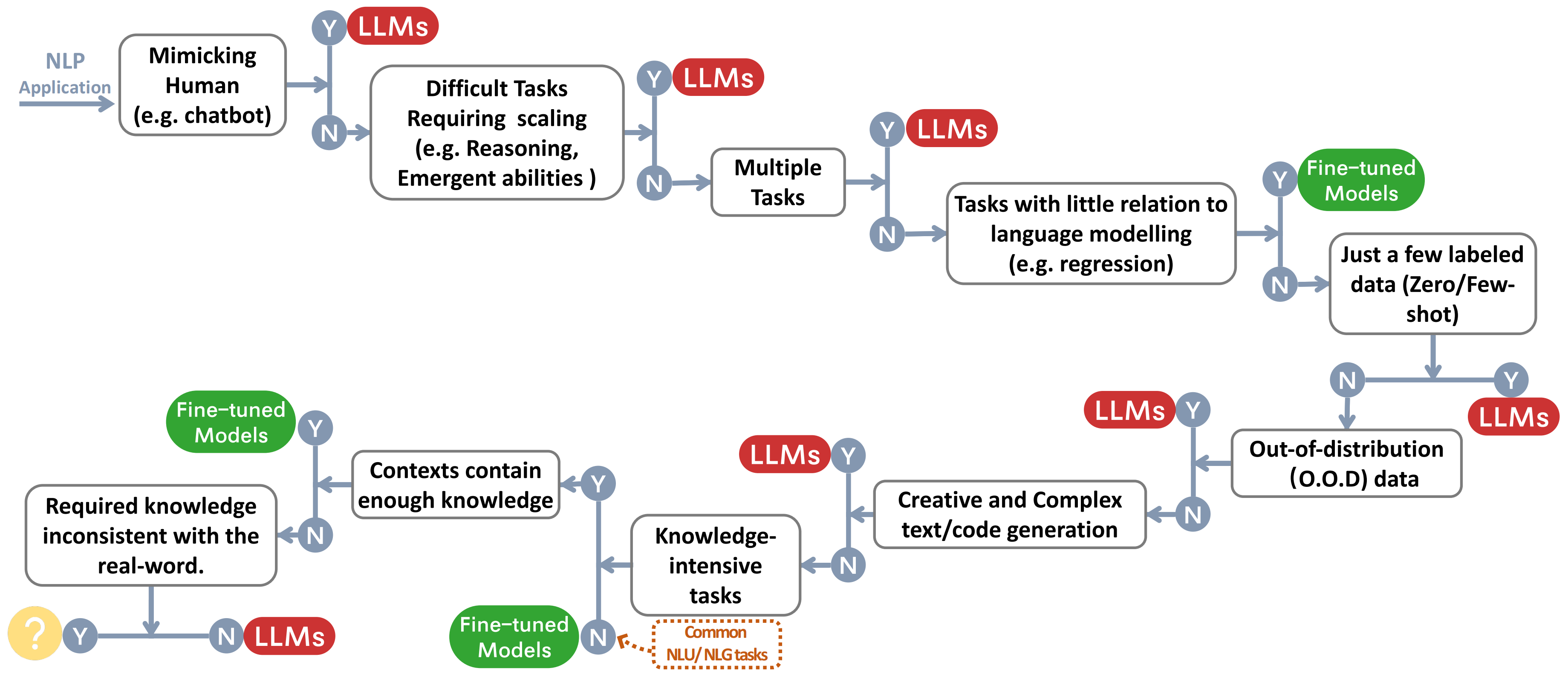

(how to choose appropriate models for downstream tasks.)

3.1 Pretraining data

- The data is carefully curated to ensure a comprehensive representation of human knowledge,

linguistic nuances, and cultural perspectives. - The importance of pretraining data lies in its capacity to inform the

language model with a rich understanding ofword knowledge, grammar, syntax, and semantics, as well as the ability

to recognize context and generate coherent responses. - the selection of LLMs highly depends on the components of the pretraining data.

- In brief, when selecting LLMs for downstream tasks, it is advisable to choose the model pre-trained on a similar

field of data.

3.2 Finetuning data

(have different scenarios)

- Zero annotated data:

- utilizing LLMs in a zero-shot setting proves to be the most suitable approach

- catastrophic forgetting is avoided.

- Few annotated data:

the few-shot examples are directly incorporated in the input prompt of LLMs, which

is named as in-context learning, and these examples can effectively guide LLMs to generalize to the task. - Abundant annotated data:

- both fine-tuned models and LLMs can be considered.

- In a brief summary: LLMs are more versatile w.r.t. the data availability, while fine-tuned models can be considered

with abundant annotated data.

3.3 Test data/user data

problem:distributional differences between the test/user data and that of the training data.

The Reinforcement Learning

from Human Feedback (RLHF) method has notably enhanced LLMs’ generalization capabilities.

4 PRACTICAL GUIDE FOR NLP TASKS

(introduce)

4.1 Traditional NLU tasks

including text classification, named entity recognition (NER), entailment prediction, and so on.

| 方面 | 优点 | 缺点 |

|---|---|---|

| 自然语言理解任务的性能 | - 在大多数传统自然语言理解任务中,如GLUE[106]和SuperGLUE[105]中的任务,如果任务提供了丰富的、良好注释的数据,并且测试集上几乎没有超分布的情况,Fine-tuned models仍然具有更好的性能。对于不同的任务和数据集,Fine-tuned models与LLMs之间的差距不同。 | - 在文本分类中,对于大多数数据集,LLMs的性能略逊于Fine-tuned models。对于情感分析,如在IMDB [69]和SST [94]上,Fine-tuned models和LLMs表现一样好。但对于毒性检测这一标志性文本分类任务,差距较大。所有的LLMs在这个任务上表现都不好,在CivilComments [13]上,即使最好的LLM也只比随机猜测[59]好一点。相反,大多数流行的Fine-tuned models可以获得更好的性能[33]。而Perspective API 3仍然是检测毒性的最佳之一。这个API由一个基于多语言BERT模型的团队提供,该模型是在公开可用的毒性数据上调整的,并使用该模型中的几个较小的单语言CNN进行提炼。这可能是因为毒性是由语言表达中的微妙差异定义的,大型语言模型仅仅基于提供的输入无法准确理解这个任务。 |

| 任务特定性能 | - LLMs在杂项文本分类任务上表现出色,处理各种主题和类别。 | - 对于情感分析、问答等任务,Fine-tuned models始终优于LLMs。 |

| 适应特定NLU任务 | - LLMs在对抗性NLI (ANLI)[74]等任务中表现出色,特别是在R2和R3回合上。这展示了LLMs在传统NLP任务的超分布和稀疏注释数据上的卓越泛化能力,超过了Fine-tuned models。 | - 对于大多数传统NLU任务来说,由于在基准数据集上的性能更好和计算成本更低,Fine-tuned models是更好的选择。LLMs在某些特定任务上有困难,比如毒性检测。 |

| 信息检索(IR)任务 | - LLMs在IR任务中尚未广泛应用。主要原因是IR任务与其他任务根本不同。将成千上万的候选文本转换成LLMs所需的少量/零次指令形式的方法是不存在的。现有的MS MARCO(regular/TREC)[73]上的评估结果表明,基于Fine-tuned models的方法具有更好的性能[59]。在这个评估中,LLMs以一种非主流的方式对段落进行排名,这要求LLMs逐个为段落产生概率。 | - LLMs在IR任务中的评估结果与基于Fine-tuned models的结果相比比较差。 |

| 低级中间任务 | - LLMs在命名实体识别(NER)和dependency parsing等低级中间任务中的结果有限,因为LLM评估的重点是实际任务。 | - 在NER等中间任务上,LLMs的性能不如Fine-tuned models。 |

| 计算成本 | - 与LLMs相比,Fine-tuned models更有优势,因为LLMs的规模通常是Fine-tuned models的10倍甚至100倍。 | - LLMs在某些任务上性能较差的一个可能原因是指令/提示的设计。将诸如IR和句子标签等任务的输入转换为少量/零次指令形式是非常困难的。 |

| 未来展望 | - 对微调模型的能力上限尚未达到,FLAN-tuning等方法可以进一步提高NLU任务的性能。 | - 未来可能会有更好的方法来使语言模型适应传统NLP任务。在NLU任务中,Fine-tuned models的性能通常比同等规模的自回归语言模型更好,而一些最新的结果表明这种差距可以通过扩大规模来弥合[22]。 |

4.2 生成任务

| 方面 | 优点 | 缺点 |

|---|---|---|

| 生成任务 | - LLMs在生成任务中表现出色,要求对输入内容有全面的理解和一定的创造力。 | - 在需要理解和创造力的任务中,LLMs展示出卓越的性能,彰显了它们在生成任务中的优势。 |

| 摘要任务 | - 在传统的ROUGE等自动评估指标下,LLMs在摘要任务中可能没有明显的优势。 | - 在考虑到真实性、连贯性和相关性等方面时,人们更倾向于LLMs生成的结果。当前评价指标可能缺乏评价高质量的摘要或适用于摘要评估的指标。 |

| 机器翻译 (MT) | - LLMs可以进行胜任的翻译,特别擅长将一些稀有语言的文本翻译成英文。 | - 在MT中的平均性能可能略逊于一些商业工具。BLOOM在更多多语言数据上预训练,展示了更好的翻译质量。LLMs的翻译能力可以通过在预训练中加入更多多语言文本来进一步提高。 |

| - LLMs在开放式生成方面表现出色,生成的新闻文章几乎无法与真实新闻文章区分,同时在代码生成方面表现出色。 | - 在编码任务和开放式生成中表现良好,但需要对生成的代码进行仔细测试以发现微妙的错误,这是在代码合成中应用LLMs时面临的主要挑战。 | |

| - Fine-tuned models,如DeltaLM+Zcode,在rich-resource和low-resource的翻译任务中表现最佳。 | - 在rich-resource翻译中,Fine-tuned models略优于LLMs。在low-resource中,如英语-哈萨克语翻译,Fine-tuned models明显优于LLMs。 |

4.3 Knowledge-intensive tasks

| 具有丰富的实际知识,通过亿级的训练标记和参数,语言模型(LLMs)比Fine-tuned models拥有更多的真实世界知识。 | 在闭卷问答任务中,LLMs在几乎所有数据集上的性能都更好,如在NaturalQuestions、WebQuestions和TriviaQA上。 |

| 在TriviaQA上,即使是零射击(zero-shot)LLMs也比其他模型好得多。 | 在大规模多任务语言理解(MMLU)中,需要对57个不同主题的多项选择问题进行理解,对模型的通用知识要求较高。 |

| 对于某些Big-bench中的任务,LLMs在需要记忆真实世界知识的情况下性能更好,有些甚至超过人类平均水平。例如,任务Hindu_knowledge要求模型提供有关印度教神话的事实,Periodic Elements要求模型能够从周期表中预测元素名称,Physics测试模型的物理知识,要求解给定物理问题所需的公式。 | 在某些任务中,LLMs的能力并不比小型Fine-tuned models更出色。例如,在机器阅读理解(MRC)任务中,只需模型理解输入段落中的自包含知识即可。 |

| 部分任务需要的知识与LLMs所学习的关于现实世界的知识不同,LLMs在这些任务上并没有明显优势。 | 在一些任务中,LLMs对于任务无用的真实世界知识,甚至需要的知识与现实世界相悖,因此在这些任务上无法很好地工作。 |

| 对于某些任务,通过检索增强,LLMs可以获得额外的知识,从而使闭卷问答任务变成“开卷”任务。 | 在某些情况下,LLMs的不一致知识可能使其性能不如随机猜测。例如,在Big-Bench中,Mnist ascii任务要求模型根据ASCII艺术图来判断表示的数字,这与现实世界知识无关。 |

| 在自包含知识的上下文中,小型Fine-tuned models的性能比较好。 | 在某些情况下,LLMs的知识与任务无关,甚至可能导致性能比随机猜测还差。 |

| 在某些情况下,通过检索增强,闭卷问答任务可以转变为“开卷”任务,使得小型Fine-tuned models具有较好的性能。 | 需要对额外知识进行检索的情况下,Fine-tuned models相对于LLMs更为适用。 |

4.4 Abilities Regarding Scaling

在这段文字中,作者介绍了大型语言模型(LLMs)的使用案例,并重点讨论了推理和新出现的能力。

4.4.1 使用案例与推理

推理是人类智能的重要方面,涉及理解信息、做出推断和做决策。这对自然语言处理(NLP)来说是一个挑战。推理任务可以分为常识推理和算术推理两类。

算术推理/问题解决: 随着模型大小的增加,LLMs在算术推理方面的能力得到了显著提升。GPT-3的两位数加法能力只在参数数量超过130亿时才显现出来。LLMs在一些任务上的性能与专门设计的方法相媲美,例如GSM8k、SVAMP和AQuA。特别是在ARC-C这样的包含难度较大问题的数据集上,GPT-4的性能接近100%(96.3%)。

常识推理: 常识推理不仅要求LLMs记住事实知识,还需要进行多步推理。随着模型大小的增长,常识推理逐渐增强。相对于精调模型,LLMs在许多数据集上仍然保持优势,如StrategyQA和ARC-C。在ARC-C上,GPT-4的性能接近100%。

4.4.2 具有新出现能力的情况

模型的扩大规模还赋予了模型一些前所未有的能力。这些能力是在较小规模模型中不存在但在大规模模型中存在的能力。处理词汇操纵是一个典型的新出现能力,如单词倒序、单词排序和单词解散任务。逻辑能力在模型扩大规模时也出现了,如逻辑推理、逻辑序列和逻辑网格谜题。其他任务,如高级编码(自动调试、代码行描述)和概念理解(新概念、简单的图灵概念),也是在模型规模扩大后出现的。

4.4.3 其他情况

尽管在大多数情况下,更大的模型带来更好的性能,但在选择适当的模型时仍需考虑许多异常情况。某些任务随着LLMs的规模增加,性能开始下降,如Redefine-math、Intothe-unknown和Memo-trap。这被称为逆向缩放现象和U形现象。逆向缩放现象是指随着模型大小的增加,其在某些任务上的性能最初会提高,然后开始下降,最终再次提高,如Hindsight-neglect、NegationQA和Quote-repetition。因此,在选择是否使用更大的LLMs时,应注意性能下降的风险,尤其是对于与上述任务类似的任务。

深入了解LLMs的新出现能力、逆向缩放现象和U形现象对于推进该领域的研究至关重要。作者指出,U形现象表明小规模模型和大规模模型使用不同的内部机制进行预测。对于新出现能力的解释可能涉及任务的多个关键步骤,LLM只有在足够大的情况下才能处理每个步骤。对于逆向缩放现象和U形现象的解释主要集中在模型对其先验信息的过度依赖,以及在困难任务中存在误导性的简单任务。解释这些现象的行为仍然是一个未解决的问题。

4.5 杂项任务

总的来说,LLMs(大型语言模型)在一些任务上存在挑战,主要是由于目标和训练数据的差异。尽管LLMs在各种自然语言处理任务中取得了显著的成功,但它们在回归任务中的性能相对较差。回归任务通常涉及预测连续值而不是离散标签,对LLMs提出了独特的挑战。这种性能不佳的一个主要原因是语言建模目标与回归任务目标之间的固有差异。LLMs的设计是为了预测序列中的下一个单词或生成连贯的文本,其预训练侧重于捕捉语言模式和关系。因此,它们的内部表示可能不太适合建模连续数值输出。此外,LLMs主要是在文本数据上训练的,专注于捕捉自然语言处理的复杂性。因此,它们在涉及处理文本、图像、音频、视频、动作和机器人等多种数据类型的多模态数据上的表现仍然大多未被探索。尽管像BERT和PaLI这样的微调的多模态模型在视觉问答(VQA)和图像字幕等许多任务上仍然占主导地位。然而,最近推出的GPT-4已经在多模态融合方面迈出了一步,但其能力尚未进行详细评估。

然而,LLMs在某些任务中表现出色。它们在模仿人类、充当聊天机器人以及执行各种任务方面非常擅长。以LLMs为基础的ChatGPT7在与人类进行多次对话时表现出一致性、可靠性、信息量丰富和健壮性,人类反馈程序在获取这些能力方面起到了重要作用。LLMs既可以充当良好的注释器,又可以用于数据增强的数据生成器。有研究发现,某些LLMs在某些任务上的表现与人类注释者一样出色。同时,从GPT-3.5(text-davinci-003)收集的文本已被用作类似人类指示的演示,用于训练其他语言模型。

此外,LLMs还可用于某些自然语言生成(NLG)任务的质量评估,例如摘要和翻译。在摘要任务中,作为评估器的GPT-4与人类的相关性较其他方法高得多。其他基于LLMs的评估器在更多NLG任务中也表现出良好的人类对齐性,特别是与传统自动指标相比。然而,LLM评估器可能对LLM生成的文本存在偏见。正如前文所讨论的,LLMs的一些能力除了提高性能外,还带来了额外的好处,如可解释性。LLMs的CoT推理能力可以展示LLM如何达到预测,这对于单个实例的解释是有益的,同时也提高了性能。

4.6 现实世界的“任务”

在本节的最后部分,讨论了LLMs和Fine-tuned models在现实世界的“任务”中的使用。在这里,“任务”一词使用得较为宽泛,因为现实世界的情景通常缺乏类似学术界那样明确定义的格式。许多对模型的请求甚至不能被视为自然语言处理(NLP)任务。模型在现实世界中面临三个方面的挑战:

嘈杂/非结构化输入。现实世界的输入来自于真实世界的非专业人士。他们对如何与模型进行交互或甚至不能流利使用文本了解甚少。因此,现实世界的输入数据可能会很混乱,包含打字错误、口语和混合语言,与用于预训练或微调的规范数据不同。

学术界未明确定义的任务。在现实世界的情境中,任务通常由学术界定义得模糊,并且比学术环境中的任务更加多样化。用户经常提出的查询或请求无法明确地归入预定义的类别,有时一个查询中可能包含多个任务。

遵循用户的指令。用户的请求可能包含多个隐含意图(例如,对输出格式的特定要求),或者没有后续问题的情况下,他们对所需的预测可能不太清晰。模型需要理解用户意图并提供与这些意图一致的输出。这些挑战主要源于现实世界中用户请求明显偏离任何为特定任务设计的NLP数据集的分布。公共NLP数据集不能反映模型的实际使用方式。

总的来说,相比Fine-tuned models,LLMs更适合处理现实世界的情境。然而,在实际世界中评估模型的有效性仍然是一个悬而未决的问题。

处理这种现实世界的情境需要应对模糊性、理解上下文和处理嘈杂的输入。与Fine-tuned models相比,LLMs更适合,因为它们已经在包括各种写作风格、语言和领域的多样数据集上进行了训练。此外,LLMs展示了在生成开放领域响应方面的强大能力,使它们非常适合这些情境。另一方面,Fine-tuned models通常针对特定、明确定义的任务,但可能难以适应新的或意外的用户请求。它们严重依赖明确的目标和规范的训练数据,这些数据规定了模型应学习遵循的指令类型。由于其对特定分布和结构化数据的狭窄关注,Fine-tuned models可能在面对嘈杂的输入时遇到困难。通常需要额外的系统作为助手,以处理非结构化的上下文,确定可能的意图,并相应地优化模型的响应。此外,一些机制,如指令调整和人类对齐调整,进一步提升了LLMs理解和遵循用户指令的能力。这些方法改善了模型生成有帮助、无害和真实响应的能力,同时保持了一致性和连贯性。虽然这两种方法都可以使LLMs更好地推广到未见过的任务和指令,但有人注意到,虽然人类标记者更喜欢针对人类对齐进行调整的模型,而不是使用公共NLP任务(如FLAN和T0)的指令进行调整,但这可能与Fine-tuned models相对较差的原因相似:公共NLP任务/数据集设计用于简单和自动评估,它们只能涵盖现实世界使用的一小部分。在涉及到现实世界情境时,主要问题之一是如何评估模型的好坏。没有任何明确定义的任务或指标,模型效果的评估只能依赖于人类标记者的反馈。考虑到人类评估的复杂性和成本,目前尚未进行过Fine-tuned models和LLMs之间的大规模和系统的比较。尽管如此,像ChatGPT这样的LLMs取得的巨大成功和受欢迎程度,从某种程度上证实了LLMs的优越性。

5 其他方面

虽然通用大模型适用于很多下游任务,但还有一些重要方面需要考虑,例如效率和可信任度。

5.1 效率

实际部署除了要考虑模型准确性,性能、成本和延迟都是重要考虑因素,。

实践中,从业者必须考虑效率和效果(efficiency with effectiveness)之间的平衡。

5.1.1 成本

近年来,LLM 变得越来越大,例如 GPT-1、GPT-2 和 GPT-3 等模型分别拥有 0.117b、1.5b 和 175 个参数。

- LLM 的训练费用跟参数大小直接相关,

- T5 11b 规模的模型单次训练成本预估超过 130 万美元,

- GPT-3 175B 单次训练需要 460 万美元 [3]。

- 训练大模型的能耗同样惊人,

- 训练一个 6b transformer 总能消耗估计约为 103.5 Mwh [30],

- Google 称,训练 PaLM 两个月左右耗费约了 3.4 Gwh [6]。

- 数据集大小也随模型大小迅速膨胀,

GPT-3 175B 训练了 4990 亿个 token [16]。

4.反映计算成本的另一个关键指标是 Flops,- T5 11B 模型只需要 3.3x10^22,

- GPT-3 175B 需要 3.14x10^23 Flops,大了 10 倍。

除了这些成本,硬件要求也很高。 OpenAI 与 Microsoft 合作,在 Microsoft Azure 中托管了一个超级计算机, 由 285k 个 CPU 和 10k 个高端 GPU 组成,支撑大型模型训练。

对于 OpenAI API 的用户,定价基于模型和使用情况而变化,例如

- GPT-3.5-turbo 通用聊天服务的收费标准为 $0.002 per 1k token;

- 对于需要定制模型的用户,训练成本为每 $ 0.003 per 1k token,使用成本为 $0.12 per 1k token [4];

因此,对于无法承担如此高成本的用户,例如小型初创企业、个人用户等, 选择一个更小的(非 GPT)微调模型可能更合适。

5.1.2 延迟

延迟是实际部署 LLM 需要考虑的关键因素。

推理时间是衡量延迟的常用指标,它高度依赖于模型大小、架构和 token 数量。例如,

- 最大 token 分别为 2、8 和 32 时,GPT-J 6B 模型的推理时间分别为 0.077s、0.203s 和 0.707s。

- 最大 token 固定为 32 时,InstructGPT 模型(davinci v2)的推理时间为 1.969s。

- 由于 LLM 通常太大而无法在用户的单台机器上运行,公司通过 API 提供 LLM 服务。 API 延迟可能因用户位置而异,

- OpenAI API 平均延迟时间从几百毫秒到几秒不等。

对于无法接受高延迟的情况,大型 LLM 可能不适用。例如,在许多信息检索应用中,可扩展性至关重要。

搜索引擎需要非常高效的推理,否则就没有意义。

InstructGPT davinci v2(175B*)的理想去噪推理时间(idealized denoised inference time) (i.e. a query-passage pair to be scored)0.21s/request,这对于网络搜索引擎来说太慢了。

5.1.3 部分参数调优(Parameter-Efficient Tuning):降低计算和存储成本

在实践中,可能根据特定的数据集对模型进行调优。

参数效率调优(Parameter-Efficient Tuning,PET)是指 冻结预训练出的 LLM 的大部分参数,只对模型的一小部分参数(或额外参数)进行微调的技术。 主要目标是极大降低计算和存储成本,同时保持原始模型的性能。 常见的 PET 技术包括,

LoRA(Low-Rank Adaptation,LoRA)[42]

Prefix Tuning [58]

*P-Tuning [62, 63]

以 LoRA 为例,保持预训练模型的权重,将低秩矩阵(low-rank matrices)引入到了 Transformer 架构的每一层中, 这种方式大大减少了后续任务训练的参数数量,从而提高了整体效率。

Alpaca-LoRA 将 LoRA 集成到 LLaMA-Alpaca 中,使其能够在单个 RTX 4090 上只用几小时就能运行起 LLaMA。

在将模型微调到特定任务,或微调 LLM 以满足人类对齐(human alignment)等特殊要求情况下, 这些 PFT 方法都是有用的。

5.2 Trustworthiness

鉴于法学硕士现在涉及医疗保健、金融和法律等敏感领域,确保他们值得信赖并能够产生可靠的成果至关重要。

鲁棒性和校准。 法学硕士的准确性和稳健性被证明具有非常强的相关性[59]。 对场景准确率较高的模型也具有良好的鲁棒性。 然而,在对额外的特定于应用程序的任务数据进行调整后,零样本的鲁棒性变得更差[116]。 这可能是由于过度拟合,由于模型的复杂性极高且下游任务的训练样本有限,导致泛化性较差[43]。 同样,据观察,由于过度参数化,微调模型可能会导致严重的校准错误[51]。 因此,当稳健性和校准是关键考虑因素时,微调模型可能不是最佳选择。 然而,人类对齐已被发现是增强模型鲁棒性的潜在解决方案。 InstructGPT davinci v2 (175B*) 已被证明在鲁棒性方面优于其他模型。 另一方面,实现模型的最佳校准取决于所采用的场景和适应程序。

公平与偏见。 事实证明,法学硕士表现出不同的待遇和影响,使社会偏见长期存在,并可能导致歧视 [10, 17]。 为了确保所有用户的公平和公正,在 NLP 模型的开发和部署中解决这些问题至关重要。 人口群体之间的表现差异可以作为公平问题的指标。 法学硕士特别容易受到公平问题的影响,因为在方言、宗教、性别和种族等人口类别之间观察到显着的绩效差异[59]。 然而,研究表明,将模型与人类指令保持一致可以提高 LLM 的性能,无论其大小如何,InstructGPT 模型 (davinci v2) 的性能差异比其他 LLM 更小 [23]。 虚假偏见。 在预训练和微调范式下的各种自然语言理解任务中都观察到了捷径学习问题,其中模型严重依赖于微调数据中输入和标签之间的虚假相关性进行预测[31,35,98]。 例如,在阅读理解任务中,微调模型倾向于关注问题和原始段落之间单词的词汇匹配,而忽略了预期的阅读理解任务本身[53]。 相比之下,大型语言模型并不是直接在微调数据集上进行训练,这使得它们不太可能学习微调数据集中存在的快捷特征,从而增强模型的泛化能力。 然而,法学硕士并非万无一失,在情境学习中可能会表现出一些捷径。 例如,最近的初步研究已经开始调查大规模语言模型中基于提示的方法的稳健性[111, 129]。 其中一项研究评估了 GPT-3 在文本分类和信息提取任务上的小样本学习性能 [129]。 并揭示了所检查的法学硕士容易受到多数标签偏差和位置偏差的影响,他们倾向于根据训练数据中答案的频率或位置来预测答案。 此外,这些法学硕士表现出共同的令牌偏差,偏向于其预训练语料库中普遍存在的答案。 最近的研究表明,可以通过选择适当的提示来减轻这种位置偏差[68]。 总之,虽然 LLM 显着减少了微调模型中普遍存在的快捷学习问题,但它们仍然表现出一些快捷学习问题,在下游应用程序中部署它们时应谨慎对待。

5.3 Safety challenges

LLM在推理、知识保留和编码等许多领域展示了他们极强的能力。 随着它们变得更加强大和像人类一样,它们以显着方式影响人们的观点和行为的潜力也随之增强。 因此,我们社会面临的一些新的安全挑战应该被考虑,并且在最近的研究中引起了广泛的关注 [75, 76]。

幻觉。 法学硕士有可能产生“幻觉”或生成无意义或不真实的内容,可能会对各种应用中信息的质量和可靠性产生重大负面影响。 随着法学硕士变得越来越有说服力和可信度,用户可能会对他们产生过度依赖,并相信他们能够在他们稍微熟悉的领域提供准确的信息。 如果模型生成完全错误或误导性的内容,从而导致基于该信息做出错误的决策或采取错误的行动,这可能会特别危险。 这种结果可能会在许多领域产生严重后果,例如医疗保健、金融或公共政策,这些领域中信息的准确性和可靠性至关重要。 为了缓解这些问题,人类反馈强化学习 (RLHF) 被广泛使用 [75, 77],并且法学硕士本身已被集成到循环中 [75]。

有害内容。 由于法学硕士生成的文本具有高度连贯性、质量和合理性,法学硕士产生的有害内容可能会造成重大伤害,包括仇恨言论、歧视、煽动暴力、虚假叙述,甚至社会工程攻击。 实施检测和纠正这些内容的保障措施可以缓解 [97]。 这些法学硕士还可以通过提供所需的非法信息而具有双重用途潜力,从而导致武器扩散[75]甚至恐怖主义袭击计划等风险。 至关重要的是确保负责任地使用这些法学硕士,并采取适当的保障措施来防止伤害。 此外,在现有的工作中,人类的反馈在消除有害输出方面发挥着重要作用。 隐私。 法学硕士可能面临严重的安全问题。 一个例子是用户隐私问题。 据悉,三星员工在使用 ChatGPT 处理工作时无意中泄露了绝密数据,包括新程序的源代码、与硬件相关的内部会议记录等。意大利数据保护机构 OpenAI 宣称 ChatGPT 的开发者非法收集个人用户数据,导致意大利成为第一个因隐私问题而禁止 ChatGPT 的政府 [1]。

6 总结及未来挑战

近几年大语言模型的发展正在深刻重塑自然语言处理领域。 有效地使用大型语言模型,需要了解它们在各种 NLP 任务中的能力和局限性。 本文作为一份实用指南,介绍如何在下游 NLP 任务中使用大型语言模型。

展望未来,我们认为大语言模型存在如下一些挑战:

在真实世界“数据集”上评估的模型性能。

现有的深度学习模型主要在标准学术数据集上进行评估,例如 ImageNet, 它们不能完全反映真实世界。 随着模型的进步,评估它们在现实世界的更多样化、复杂和真实的数据上的表现是至关重要的,这些数据反映了真实世界的需求。 在真实“数据集”上评估模型,需要更严格的测试其能力的方法,以及更好地了解它们在实际应用中的有效性。 这确保了模型能够应对真实世界的挑战并提供实用的解决方案。模型对齐。

- 确保日益强大和自主的模型与人类的价值观和排序保持一致至关重要。

- 必须确保这些模型符合预期行为,并且不会优化出不良结果。

- 在模型开发过程的早期阶段就关注对齐技术是至关重要的。

- 模型的透明度和可解释性也是评估和确保对齐的重要因素。

- 此外,当我们展望未来时,一个更艰巨的挑战正在逼近:与超人类系统对齐(aligning superhuman systems)。 虽然目前这项任务超出了我们的需求,但考虑和准备对齐这些先进系统的潜在影响是重要的,因为它们可能带来独特的复杂性和伦理问题 [8, 15]。

- 安全对齐。

虽然讨论 AI existential risks 的重要性不言而喻,但我们需要具体的研究来确保高级人工智能的安全开发(safe development of advanced AI)。 这包括解释性技术、可扩展的监督和治理方法,以及对模型属性进行形式化验证 (interpretability, scalable oversight and governance, and formal verification of model properties)。 安全性不应该被视为附加项,而应作为模型构建过程的一个组成部分。

- 通过 scaling 进行性能预测(Performance Prediction with Scaling)。

随着模型规模和复杂性的大幅增加,我们很难预测模型性能的变化。 开发更好地预测模型性能预测方法,或提出一些新架构,将使资源的利用更加高效,训练过程也将得到加速。 一些可能的方法包括:

- 训练一个较小的“种子”模型并推断其增长(extrapolating its growth),

- 模拟 increased scale 或 model tweaks 的效果,

- 在不同规模上对模型进行基准测试以建立 scaling laws。

这些方法可以在模型构建之前就洞察其性能。

借用了下面的翻译:http://arthurchiao.art/blog/llm-practical-guide-zh/